Firmen führen Eignungsuntersuchungen durch, um aus einem Feld von Bewerbenden künftige Mitarbeiterinnen und Mitarbeiter auszuwählen. Bei seriösen Firmen werden die Auswahlkriterien durch spezifische Stellenprofile festgelegt. Denn jede Position und jeder Ausbildungsplatz bringt bestimmte allgemeine und spezielle Anforderungen mit sich. Psychologische Eignungstests zielen darauf ab, die Fertigkeiten und Fähigkeiten, die mit diesen Anforderungen zusammenhängen, so zu überprüfen, dass man die am besten passenden Bewerberinnen und Bewerber identifizieren kann. Je allgemeiner dabei vorgegangen wird, desto schwieriger ist es, sich von Schulnoten oder Intelligenztests abzusetzen. Und je näher man sich an letztere anlehnt, desto eher wirkt man allen Diversity-Maßnahmen entgegen. Denn solche Tests sind selten kulturfair. Ein Grund, warum Eignungstests wie sie hierzulande gebräuchlich sind, in den USA schon längst verboten wären (adverse impact). Je fachspezifischer die Tests zur Eignungsfeststellung sind, desto höher ist die prognostische Validität (Vorhersagegüte) für späteren beruflichen Erfolg, ein wesentliches Gütekriterium für alle Eignungsverfahren. Wenn man davon ausgeht, dass die abgefragten Wissensformen überhaupt entscheidend im normalen Berufsalltag sind – was nur für wenige Berufe möglich ist. Warum also sollte man Geld und Zeit für Eignungsverfahren investieren, wenn die ausgewählten Personen gut abschneiden bei Aufgaben, die so oder ähnlich nie wieder im Berufsalltag auftauchen? Wir schauen den drei größeren Testdienstleistern unter die Motorhaube: dgp, eligo und beim Berufspsychologischen Service (BPS) der Bundesagentur für Arbeit…

Leider kann psychologische Grundlagenforschung zu Kognition oder Intelligenz einige Schlüsse von Eignungsdiagnostikern aus Testergebnissen nicht belegen. Das liegt oft daran, dass die psychometrischen Modelle, also die Methoden psychologischen Messens oft nicht dasselbe fokussieren wie die eher experimentell orientierte psychologische Forschung zu demselben Konstrukt: das ist vor allem bei Intelligenz und kognitiver Leistungsfähigkeit der Fall. Denn die vielen Tests zugrunde liegende Intelligenzmodelle mit visueller, begrifflicher oder räumlicher Intelligenzleistung prüfen die verschiedenen Formen kognitiver Belastung sehr einseitig, was im Berufsleben klaren Routinen wie im Controlling oder der Leistungsabrechnung entspricht. Ab einem bestimmten Zeitpnkt prüft man vor allem Aufmerksamkeit und Fokusleistung statt Intelligenz. Außerdem werden überdurchscnittlich intelligente Menschen durch Routinen schneller demotiviert als andere. Wähle ich Probanden, die in solchen Routinen überdurchschnittlich gut abschneiden, ist die innere Kündigung durch Monotonie vorprogrammiert. Aber schauen wir in die Praxis und begegnen dabei zuerst einer DIN-Norm, die die Spreu vom Weizen trennen soll.

Damit Eignungsdiagnostik nicht ins Kaffeesatzlesen und Irisdiagnose abdriftet, wurde die Dienstleistungsnorm DIN 33430 eingeführt, die leider die psychometrischen Messinstrumente selbst nicht bewertet (das wäre eine Produktnorm), aber für den gesamten Auswahlprozess von der Planung bis zur Durchführung sowie bei der Wahl der Dienstleister Qualität gewährleisten soll.

Folgende Aspekte schreibt die DIN 33430 verbindlich vor:

– es müssen zunächst die Ergebnisse einer Anforderungsanalyse für die Position vorliegen,

– die Eignungsmerkmale Bewerbender sollen durch verhaltensnahe Beschreibungen konkretisiert sein,

– es dürfen nur Verfahren eingesetzt werden, für die ein eindeutiger Bezug zu den obigen Anforderungen belegt (es braucht also eine möglichst neutrale Studienlage) ist,

– zu den Eignungsverfahren müssen Handhabungshinweise bzw Manuale zur Durchführung vorliegen.

– daraus folgt, dass neben einer allgemeinen Eignung zur Testdurchführung auch eine Aus-/Weiterbildung zur Handhabung spezifischer Testverfahren für die Durchführenden Pflicht sein sollte.

Ich empfehle bei meinen Mandaten immer als Grundlage für ein Qualitätsmanagement der Verfahren, dass die Anbieter die Konstruktvalidität für die Variablen nachweisen müssen, die sie mit ihren Verfahren durch führen. Denn DIN 33430 fokussiert nur den Prozess und nicht die Verfahren selbst. Viele wurden entwickelt, als es noch keine Replikationskrise, keine Korrektur für publication bias und keine explorative Analyse und Faktorenprüfung mit ESEM und ähnliche moderne Verfahren gab. Auch kausale Modelle fehlen weitegehend, warum eine Mathenote – über mehrere Jahre in der Schule erhoben – weniger valide sein soll bei Schulabgängern als ein einmaliger kognitiver Test wie bei eligo oder der dgp , der selten Anderes erhebt als numerische Kompetenz.

Allein mit Blick auf diese Liste der BIN33430-Kriterine fällt der Großteil derjenigen Verfahren aus, die oft von Personalern genutzt werden, wie etwa Meyers-Briggs-Typenindikator, DISG, persolog, Reiss-Profile etc. Uwe-Peter Kanning hat 2015 zu diesen Verfahren und vielen anderen spannenden Themen rund um Eignungsfeststellung in seinem Buch Stellung bezogen: Personalauswahl zwischen Anspruch und Wirklichkeit.

Allegmein gesagt, soll mittels DIN 33430 prüfbar sein, ob es bei der Auftragsklärung, bei der Stellenanalyse, der Testplanung, der Durchführung sowie beim Messen objektiv, zuverlässig (reliabel) und gültig (valide) zugeht. Validität erfordert eine gute theoretische Basis (die durch psychologische Grundlagenforschung oft nur teilweise vorliegt). Sie wird gewährleistet durch eine inhaltliche Repräsentation des interessierenden Merkmals durch eindeutige Beziehung der Fragen oder Aufgaben zum Konstrukt Fachwissen, Intelligenz oder Aufmerksamkt. Und vor allem muss der Zusammenhang mit relevanten Merkmalskomplexen (sogenannten Kompetenzen) belegt sein. Letzteres ist für die Interpretation der Ergebnisse zentral, da beruflicher Erfolg sehr oft sehr viele Mütter und Väter hat, die bei einem Eignungstest weder bedacht noch erhoben werden können. Erwähnenswert ist zusätzlich der Fokus auf eine Kosten-Nutzen-Kalkulation. Denn schließlich kostet ein Verfahren wie stundenlange Intelligenztests oder Assessment und Development Center alle Beteiligten viel Geld, Zeit und Nerven. Wenn man gängige Eignungstests betrachtet, gibt es vor allem zwei Arten:

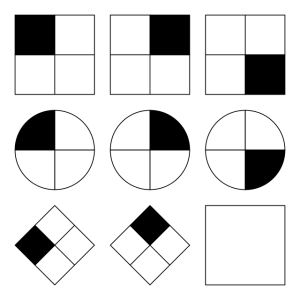

1. Tests, die ähnlich wie Intelligenz- oder Aufmerksamkeitstests alle kognitiven Fähigkeiten prüfen, die mit der mentalen Verarbeitung von Informationen einher gehen: Ob Matheaufgaben, möglichst schnelle Reaktion auf bestimmte Signale wie blaue Dreiecke oder Buchstaben auf einem Monitor, das Beantworten von Fragen zum Allgemein- oder Fachwissen. Ein sehr großer Teil dieser Aufgaben fragt Erlerntes aus der Schule ab oder basiert auf Mathematikregeln. Manche führen logisches Schlussfolgern ein, in der Hoffnung, damit etwas auf der Spur zu sein, was Kognitionspsychologen unter Intelligenz verstehen: das Lösen bisher unbekannter Aufgaben mit bekannten Mitteln oder bekannter Aufgaben mit bisher unbekannten Mitteln. Im Gegensatz dazu messen viele psychometrische Modelle der Intelligenz jedoch vor allem formalisiertes Denken mit Aufgaben aus Zahlen, Begriffen oder Symbolen. Beide Ideen treffen sich in der sogenannten fluiden Intelligenz, die gern kulturübergreifend mit Matrizentests (siehe Bild oben) gemessen wird. Denn es hat sich gezeigt, dass Menschen aus verschiedenen Kulturen unterschiedlich auf psychometrische Intelligenztests reagieren. Wer also einen Eignungstest schlicht analog zu IQ-Tests mit formalisiertem Denken abprüft, diskriminiert potentiell schon im Verfahren selbst bestimmte Anspruchsgruppen (Plomin et al., 2014, siehe auch adverse/disparate impact im amerikanischen Personalwesen). Fluide Intelligenz, die als mentales Ergänzen von Symbolen gepürft wird, um eine Reihe geometrischer Figuren zu vervollständigen, weist aber auf ein grundsätzliches Problem. Was Wirtschaftspsychologen als kognitive Leistung im Beruf analysieren, hat wenig mit dem zu tun, was Psychometriker (Testentwickler) für Eignungstests entwerfen. Schon früh wurde daher gefordert, dass Messverfahren äquivalent zum Zielkriterium (in diesem Fall beruflicher Erfolg) erhoben werden müssen. Denn sonst misst man zwar akademisch wertvoll rum, kann aber den Bezug zur professionellen Anforderung und vor allem der erfolgreichen beruflichen Zukunft nicht belegen. Wer sich für dieses Problem interessiert, möge das Linsenmodell von Egon Brunswick genauer unter die Lupe nehmen, das in der Diganose- und Urteilsforschung relevant geworden ist.

2. Die zweite Kategorie versucht Persönlichkeitseigenschaften im Selbstbericht abzufragen. „Am glücklichsten bin ich, wenn viele Menschen mich bewundern und schätzen, was ich mache.“ Antwortmöglichkeiten sind dann: „trifft gar nicht zu, trifft eher nicht zu, trifft eher zu, trifft genau zu“. Hier ist das Problem der Kulturabhängigkeit noch viel beeindruckender. Menschen aus kollektiven Gesellschaften sind geprägt, anderen, vor allem der Familie zu helfen. Wettbewerb oder Distinktionsbedürfnis, wie es in individualistischen Gesellschaften gefördert wird, kommt in sozialen Situationen außerhalb von Sportveranstaltungen selten in Betracht oder wird sogar belächelt. Die oben aufgezählten Persönlichkeitstests wie etwa Meyers-Briggs, disg oder Rollenprofile aus der Teamwelt verlassen selten das Niveau von Astrologie oder Kartenlegen (mehr dazu in diesem Video von Prof Kanning). Für sie wurde bisher weder Messgenauigkeit (Reliabilität) noch Validität belegt. Aber selbst das bekannteste realiable und valide „Testverfahren“ basiert auf einem mehrdimensionalen persönlichkeitspsychologischen Modell namens BIG5, das fünf basale Persönlichkeitseigenschaften postuliert:

1) Neurotizismus (Neigung zu emotionalen Stimmungen wie Ängstlichkeit und Traurigkeit),

2) Extraversion (Neigung zur Geselligkeit und Optimismus),

3) Offenheit für Erfahrung (Neigung zum Wissen, Neugier und neuen Erfahrungen),

4) Verträglichkeit (Neigung zum Blick auf Andere und Kooperation)

5) Gewissenhaftigkeit (Neigung zur Disziplin undzur Zuverlässigkeit).

Leider fallen die Ergebnisse in verschiedenen Ländern sehr unterschiedlich aus. Das Modell bildet Perönlichkeitsdimensionen also nicht kulturübergreifend gleich ab. Psychometrisch gesprochen sagt man dann, dass skalare Messinvarianz nicht gegeben ist. Dieser sperrige Begriff meint, dass nur die Tests psychologische Konstrukte richtig messen, die belegen können, dass bei Mehrgruppenvergleichen die Werte für Frauen, Männern, Muslime, Buddhisten sowie Menschen aus kollektiven oder individualistischen Gesellschaften, Alte und Junge überall auf der Welt die Messungen vergleichbar sind. Wenn es also signifikante Unterschiede zwischen älteren und jungen Leuten gibt, ist der Test eigenlich nicht nutzbar und potentiell diskriminierend. Denn die Unterschiede der Messwerte zwischen Menschen soll durch verschieden ausgeprägte Merkmale der Indivdiuen und nicht durch deren Gruppenzugehörigkeit verursacht sein. Aber auch wenn man die modernere, gerechtere, kulturfaire Abwandlung der BIG5 mit nunmehr sechs Faktoren nutzt, bleiben Fragen, wie Eigenschaften einer Person den beruflichen Erfolg vorhersagen können sollen. Beim Fleiß, den Psychologen allgemeiner unter Gewissenhaftigkeit subsummieren, ist das offensichtlich. Bei Verkäufern ist auch noch die Geselligkeit und Offenheit leicht erklärbar. Denn wer nicht gerne auf fremde Menschen oder neue Situationen zugeht, wird im wuseligen Verkaufsraum oder auf Messen eher Probleme haben, Produkte oder Beratung an den fremden Mann oder die Frau zu bringen. Ganz anders sieht das bei Verträglichkeit (Empathie und Rücksichtnahme) oder dem Neurotizismus (emotionale Stabilität) aus. Diese Eigenschaften sind sicher relevant für den Erfolg im Leben ganz allgemein, aber in welchem Ausmaß und für welche Teilaufgabe unterscheidet sich zwischen Personalbuchhaltung, Busfahren und Herzchirurgie deutlich, oder eher nicht? Es gibt dazu Forschung, die oft nicht repliziert wurde und ähnlich wie beim Zusammenhang zwischen Berufserfolg und Intelligenz nach Korrekturen für publication bias (nur signifikante Ergebnisse werden publiziert) höchstens kleine Zusammenhänge aufklärt und bei Kausalität wird es dann ganz stumm. Denn Langzeituntersuchungen ermöglich im Grunde keine kausalen Aussagen, erst recht nicht seit die gebräuchlichen Cross-Lagged-Panel-Modelle weitgehend obsolet sind. Kein Experiment, keine Kausalität. Aber auch ganz ohne empirische Kenntnisse erschließt sich das: Auch wenn man 20 Jahre lang ferststellt, dass im Frühjahr, wenn die Störche wieder kommen, mehr Babys geboren werden als sonst im Jahr – kausal wird dieser Zusammenhang auch nach 50 Jahren nicht. Zudem ist der Einfluss einer Persönlichkeitseigenschaft je Situation unklar: Ist es besser in diesem Meeting den Mund zu halten und andere reden zu lassen und im nächsten Meeting nicht? Oder soll man sich besser einbringen, damit viele Perspektiven gehört werden. Das ist sehr stark von der Situation, der Aufgabe und eben der beruflichen Rolle abhängig. Es wäre also viel schlauer, zu messen, wie flexibel jemand auf verschiedene Situationen und unterschiedliche berufliche Rollen reagieren kann. Authentizität anyone?

Damit sind wir bei einem wichtigen psychometrischen und psychologischen Thema, das bisher kaum in der Debatte um Eignungsdiagnostik stattfindet. Psychologen nennen sie die State-Trait-Debatte. Denn fast alle Eigenschaften von Menschen sei es Offenheit oder Problemlösekompetenz hängen enorm von der Tagesform, dem Schlafdefizit, vorherigen Belastungen wie langen Autofahrten oder Stress zuhause ab. Und natürlich auch von der Firmenkultur, dem Chef, der netten oder fiesen Kollegin und der Qualität des Kaffees am Morgen. Diese situationsabhängigen Bestandteile einer Eigenschaften heißen „state“, also Zustand. „Trait“ meint die langanhaltenden Anteile eines Merkmals, die über Jahre entstehen (Augen auf beim Testen von persönlichen Eigenschaften bei Menschen unter 20!) und sich ab einem bestimmten Alter nur noch wenig ändern. Es sei denn, die Situation erfordert es und die Person ist reflektiert und flexibel. Man kann also in Bewerbungssituation über seine Traitanteile hinaus so tun als ob, weil man gelesen hat, dass bestimmte Eigenschaften erwünscht sind. Das verfälscht gar nicht das Testergebnis, wenn der- oder diejenige das dann auch über das ganze Berufsleben so schauspielern kann. Bei Verkaufspersonal oder Pflegepersonal ist das Darstellen von Freundlichkeit und großer Sorge um das Wohlergehen Anderer sogar explizit erwünscht. Aber diese emotionale Arbeit kostet viel Kraft und führt langfristig nicht selten zu Burnout (in diesem Umfeld ist der Begriff zuerst beforscht worden!). Sie bindet manchmal Energie, die bei anderen komplexen Aufgaben vielleicht besser aufgehoben wäre. Schauen wir uns einfach drei Anbieter und deren Tests an. Manche der folgenden Testverfahren kenne ich aus eigener Anwendung oder mindestens weil ich als Sport mich immer wieder bewerbe, um möglichst viele Anbieter, verschiedene Testverfahren und Personalabteilungen kennen zu lernen, sodass ich deren Güte und Professionaliät des Prozesses aus Sicht der Bewerbenden einschätzen kann. Zu manchen Verfahren liegen mir ältere Manuale vor, so dass einige Probleme hoffentlich mittlerweile optimiert wurden, aber es geht um einen ersten einführenden Einblick.

Wer prüft eigentlich all die Bewerber die auf Lebenszeit Beamte werden und die Angstellten, die in Kommunen, Landkreisen und Ministerien das Land am Laufen halten?

Jedes Jahr führen Anbieter wie etwa die Deutsche Gesellschaft für Personalwesen e.V. (dgp) mit Tausenden Absolventen mit mittlerem oder höherem Schulabschluss in Hunderten Behörden auf Kommunal- und Landesebene denselben gut dreistündigen Test durch, der alle paar Jahre leicht verändert wird, aber seit Jahrzehnten dieselben kognitiven Fähigkeiten mit dicken Testheften oder mittlerweile mit Tablets in der jeweiligen Behörde prüft. Für einige sind diese Tests oft der Anfang einer jahrzehntelangen Beamten- oder Angestelltenlaufbahn oder eben leider das Ende von Karriereträumen. Viele Konzerne nutzen ähnliche klassische Verfahren kognitiver Leistungstests wie die dgp, viele tun dies mittlerweile online über Anbieter wie etwa Eligo, die dieses Abtesten von in der Schule erworbenen Fähigkeiten etwas blumig mit Denkfähigkeit bezeichnen. Hoffentlich gehen sie damit über das hinaus, was die Psychologie damit meint, nämlich in der Evolution des Gehirns die Fähigkeit aus vielen Handlungsmöglichkeiten eine den eigenen Zielen und der Situation angepasste Handlung auszuwählen. Ich nehme an, sie meinen jedoch wie alle anderen höhere Kognition. Denn damit meinen Psychologen ja das mentale Aufbereiten und Verarbeiten von Informationen wie zum Beispiel Matheaufgaben oder das Umgehen mit Sprache oder Symbolen. Eligo geht über diese Leistungstest der dgp hinaus und will zum Beispiel eine Persönlichkeitseigenschaft namens Frustrationstoleranz von zukünftigen Mitarbeitenden prüfen, indem zusätzlich zu den eigentlichen Aufgaben ein Hinweisreiz über die vermeintlich bessere Leistung anderer Bewerber eingeblendet wird („82% aller Mitbewerber waren bei dieser Aufgabe besser als Sie“). Ein hohe Toleranz hat dann diejenige Bewerberin, die einfach so weiterarbeitet wie zuvor (!). Kritisch wird es, wenn medizinisch relevante Konstrukte, die aus Sicht der psychischen Gefährdungsbeurteilung zentral sind wie etwa Monotonie bei der Arbeit. Bei einem Teiltest von eligo wird die Bereitschaft gegenüber monotonen Aufgaben abgeprüft. Der Test misst dabei, ob jemand trotz Eintönigkeit engagiert weiter arbeitet. Ob diese Eigenschaften erwünscht sein sollten, kann die geneigte Leser oder der geneigte Leser besser selbst beantworten. Ob solche Prüfungen gute Operationalisierungen für Fähigkeiten im erfolgreichen Berufsleben sind, kann auch der Anbieter nicht beantworten. Repräsentativ und äquivalent zur Zielvariable wäre die Aufgabe natürlich erst dann, wenn Monotonie stundenlang erfolgen würde. Es wird also spannend, was Eignungstests sonst so alles prüfen…

First Things First

Ein großes Problem von Intelligenzstests im Speziellen und Eignungsverfahren, die kognitive Leistungsfähigkeit allgemein abprüfen wollen, liegt in der zeitlichen Länge. In der Forschung wird mittlerweile angezweifelt, ob nach 45-60 Minuten zwischen den Bewerbern nur noch Intelligenz variiert oder – um einen Begriff der dgp zu verwenden – Verarbeitungskapazität geprüft wird und ob nicht diese Unterschiede irgendwann auch durch ganz andere Konstrukte wie Aufmerksamkeitsfokus, kognitive Kontrolle oder primäre exekutive Prozesse zustande kommen. Primäre exekutive Prozesse zum Beispiel sind bei Spielen die Fähigkeiten, sich Züge auf dem Schachbrett oder bei Vier-Gewinnt im voraus auf dem Spielfeld vorzustellen und damit Grundlage für höhere Fähigkeiten wie das Entwickeln einer Strategie, das Beibehalten dieser Strategie und das Adaptieren anhand neuer Situationen. Sie sind der Kernprozess, der es ermöglicht eine Aufgabe korrekt zu erfüllen. Genau die will ein Arbeitgeber so präzsie wie möglich prüfen. Je länger man aber Schach spielt oder eben von Psychometrikern getestet wird, desto mehr überlagern überwachende Fähigkeiten diese primären kognitiven Prozesse, da sie den Fokus auf das Spiel oder die Aufgabe halten. Man merkt, dass man müde wird, durstig ist oder der Stuhl schlecht für den Rücken ist und versucht „sich zu konzentrieren“. Abzugrenzen von diesen beiden basalen Prozessen ist die kognitive Kontrolle eine Ebene höher, die größere Ziele oder Kontexte bildet („Ich muss den Eignungstest schaffen, sonst schimpft mein Vater!“) und einzelne Mittel zum Zielerreichen verfügbar macht. In keinem bekannten Eignungstest werden diese Prozesse getrennt geprüft und abgegrenzt von dem was die Psychologie als Intelligenz sieht: das Lösen bisher nicht bekannter Probleme. Also der Umgang mit Unsicherheit angesichts einer neuartigen Aufgabe, die manchmal, aber nicht immer genug Elemente enthält, um das Problem selbständig zu lösen. Manchmal muss abstrahieren vom eingeschlagenen Wegen (primäre Exekution) und manchmal muss man einfach einen neuen strategischen Ansatz wählen. Das ist es, was man in vielen beruflichen Kontexten braucht: mit neuen Problemlagen umzugehen. Dafür prüft man kognitives Potential. Will man also jemanden auswählen, der sehr gut im Problemlösen ist und schickt denjenigen in einen dreistündigen Test und traktiert ihn oder sie mit vielen verschiedenen Aufgaben, die sogar langweilen oder ermüden, wird er oder sie nachher vielleicht insgesamt beim aufsummierten Ergebnis aller Aufgaben das schlechtere Ergebnis haben als weniger intelligente Bewerbende. Man wählt also eher diejenigen, die Durchhalten und in Einzeltests insgesamt knapp überdurchschnittlich sind. Wer Schlussfolgerndes Denken oder Matheaufgaben in der Hälfte der Zeit der anderen erledigt hat, wird dann nur sichtbar, wenn er oder sie deutlich besser als alle anderen ist. Bei der Behörde ist das leider sogar noch schlimmer. Denn je höher die intellektuellen Fähigkeiten, desto größer ist die Aversion eines Mensch bei Routineaufgaben. Wer also besonders gut abschneidet und/oder eine hohe Intelligenz hat, wird voraussichtlich lange und häufige Krankheitsphasen in der beruflichen Laufbahn erleben oder gar als schlecht integrierbar gelten, da Frust (Unterforderung oder Monotonie) oft unterschwellig oder offensichtlich aggressives Verhalten bedingt. Wie also prüft man soziales Verhalten? Indem man Leute in Assessment Centern unter sozialen und mentalen Stress setzt und dann diejeniegen auswählen, die am besten geschlafen haben und daher ruhig und zielorientiert arbeiten. Oder lieber die Hibbeligen, die nicht zufrieden sind, das Mögliche rausholen wollen, die leistungsorientiert sind und daher alles hinterfragen und manchmal auf tolle Lösungen kommen, sich aber keine Freunde machen sondern den Fokus auf das Ziel halten?

Was wird eigentlich getestet?

Beim klassischen Test für Behörden wie dem der dgp soll neben der Verarbeitungskapazität auch die Bearbeitungsgeschwindigkeit, Merkfähigkeit, Arbeitseffizienz sowie Deutsch, Englisch und Allgemeinwissen erhoben werden. Für alle Bewerber unter 25 liegen immer sehr gute aktuelle Langzeitdaten zu Deutsch, Englisch, Mathematik und den Naturwissenschaften in den Zeugnissen vor. Würde man sie über die letzten drei Jahre zusammenrechnen, hätte man schulische Störfaktoren wie Lehrermeinung oder bestimmte Stoffpräferenzen gemittelt und zusätzlich die situativen Störfaktoren aus einer Bewerber-Testsituationen wie falscher Stuhl, bohrende Handwerker im Nachbarhaus oder sengende Hitze im Testraum ausgeschlossen. Zudem liegt mit der gemittelten Mathematiknote ein Wert vor, der extrem hoch mit allen bekannten Intelligenztests korreliert. Alle Testteile in Eignungsuntersuchungen die Intelligenztests ähneln, sind damit für Menschen, die direkt aus der Schule kommen vollkommen überflüssig, weil Daten mit höherer Qualität in den Zeugnissen stehen. Fachleute nennen das Testökonomie. Die Anbieter solcher Massentests liefern als bei Schülerinnen und Schülern keinen Mehrwert. Schlimmer noch, solche Tests benachteiligen Menschen mit Prüfungsangst, fördern Reaktanz und sind wenn sie nicht auf skalare Invarianz gegenüber verschiedenen Kulturen und Intersektionalität geprüft sind, im Grund unwissenschaftlich und benachteiligen zu schützende Gruppen wie Menschen mit Beinträchtigungen, mit Migrationshintergrund oder Kinder aus Familien mit geringem sozioökonomischen Status. Gegenmittel: Man muss nur, wie sehr viele deutsche Universitäten die Noten für Schulen und Bundesländer unterschiedlich gewichten, die Zeugnisnoten der letzten drei Jahre aufaddieren und lädt dann nur zu fachspezifischen Tests ein, die auf den jeweiligen Ausbildungsgang oder die jeweilige Laufbahn optimiert sind. Im öffentlichen Dienst könnte man auf diese Weise klüger mit Ressourcen wie Geld, Zeit und Akzeptanz der Bewerberinnen und Bewerber umgehen und Kommunen und Behörden so Zentausende Euro einsparen. Leider glauben viele Personaler den Dienstleistern, dass ein einheitlicher Test bessere Vergleichbarkeit gewährt. Wenn ich aber eine Schulnote über drei Jahre messe, habe ich mit dem Mittelwert viele Störvariablen ausgemittelt und vor allem mehrere Messzeitpunkte und damit einen stabilen Traitwert der numerischen oder sprachlichen Fähigkeiten, der viel besser eine Zukunftsvorhersage ermöglicht als ein nur zufällig repräsentatives Abbild an einem Testvormittag im großen Rathaussaal mit 30 anderen Bewerberinnen. Und das Testaufgaben neue Probleme darstellen gilt nur für die Bewerber, die das erste Mal zu einem Eignungstest kommen. Alle anderen haben einen enormen Vorteil, weil sie den Großteil der Aufgabenarten schon kennen. Gerecht geht anders.

Übliche Aufgaben sehen so aus:

Vervollständigen Sie die Zahlenreihe und ergänzen Sie die letzte Zahl:

6 14 30 62 126 ?

Wählen Sie nur eine Antwort: Tennisball verhält sich zu Tennisschläger wie Fußball zu…

a) Pforte

b) Tür

c) Garage

d) Tor

e) Eingang

Intelligenz, Klugheit, Kognitive Leistung und Gedächtnis

Ein anderes großes Problem haben wir noch nicht betrachtet. Wie hängen eigentlich Merkfähigkeit oder Bearbeitungsgeschwindigkeit mit Erfolg im öffentlichen Dienst zusammen? Wer schon mal ein Flussdiagramm in der Behörde gesehen hat (meist werden sie mit der Beschreibungssprache für behördliche Prozesse wie PICTURE erstellt), der wird feststellen, das sehr viele Prozessbausteine darin bestehen, auf Vollständigkeit geprüfte Daten aus einem System oder aus dem Posteingang in eine Fachanwendung zu übernehmen. Es werden Anträge entgegen genommen, deren Inhalte geprüft (bei SAP würde man es Plausibilitätscheck nennen, ob alle Inhaltstypen korrekt befüllt wurden vor der Übernahem in die Datenbank), Laufzettel erstellt, inhaltlich geprüft und dann werden Bescheide geschrieben und versendet. Die Inhalte liegen also immer vor, entweder auf Papier oder im System. Lediglich die inhaltliche Prüfung erfordert ein umfassendes Anwendungswissen aus Verordnungen, Gesetzen und Richtlinien, die untereinander auch noch je Einzelfall unterschiedliche Prüfschritte und -abhängigkeiten erfordern. Informatiker bauen für so etwas Flussdiagramme mit Weichen und Schleifen. Es ist eine Frage der Zeit, dass nur noch Sonderfälle von echten Menschen überprüft werde müssen. Aber wir waren bei der Bearbeitungsgeschwindigkeit, die die dgp mit folgenden Aufgaben überprüft, man nennt sie Zahlen- oder Buchstabenreihen.

In der folgenden Zahlenreihe sind so schnell wie möglich alle Zahlen anzustreichen, die ohne Rest durch 4 teilbar sind.

Beispiel

23 32 38 20 4 1 56 10 12 7 61

Es gibt zumeist mehrere Aufgaben, die nicht selten immer schwerer werden. Wenn ein Test immer schwerer wird, sprechen Testentwickler von Leistungs- oder auch Powertests. Das Gegenteil sind Speedtests. Da wird nicht das Niveau einer Leistung getestet, sondern bei einem niedrigen Aufgabenniveau wird nur die Anzahl der gelösten Aufgaben addiert. Wenn man also beides kombiniert, hat man weder das Niveau noch die Geschwindigkeit getestet. Addiert man dann einfach die Anzahl, verliert man das Leistungsniveau. Notiert man das das Niveau der letzten korrekt gelösten Aufgabe, hat man die Geschwindigkeit verloren.

Dieser Test mit den Zahlenreihen erscheint zunächst nichts Anderes zu sein als eine weitere Matheaufgabe. Er hat also mal wieder keinen Mehrwert als Leistungstest, der über die Mathenote hinaus ginge. Aber als Speedtest schon. Man kann dann viele Operationen im Kopf schnell hintereinander durchführen, die jedes Programm im PC deutlich schneller und präziser hinbekommt. Aber wer nutzt heutzutage schon Softwareprogramme (außerhalb von Behörden als App oder Application bekannt) für Routineaufgaben – offenbar nicht der öffentliche Dienst.

Das Testen von Bearbeitungsgeschwindigkeit scheint eher Fähigkeiten abzuprüfen, die in der Ära vor Handy und PC sehr relevant waren, aber eigentlich besser und präziser von Maschinen übernommen werden (Prüfroutinen), und so auch der Monotonie entgegenwirken, die aus psychologischer Sicht eine Gefährdung am Arbeitsplatz darstellt. Das Problem von räumlich präsentiert Zahlenwerten liegt jedoch auch noch woanders. Bei Reihen von Zahlen setzt je nach Aufgabe der SNARC-Effekt ein. Das ist ein Phänomen, dass abhängig von der erlernten Schriftkultur und anderen kognitiven Verarbeitungsschritten die Größe von Zahlen, Mengen und Beträgen je nach aufsteigender oder absteigender Reihung an die geprägte Leserichtung (von links nach rechts oder umgekehrt) koppelt. In dem Moment wo bei Zahlenreihen die Werte von links nach rechts steigen oder fallen, werde bestimmte Bewerbende bevorzugt oder benachteiligt, je nachdem wie stark der Effekt bei der Person und der geprägten Schrift/Leserichtung wirkt.

Dieser Effekt führt uns zu erlernten Mustern und damit zum Langzeitgedächtnis sowie zum sogenannten Arbeitsgedächtnis (working memory) des Gehirns und der Interaktion der beiden miteinander. Wir sind damit direkt in dem Bereich gelandet, den die dgp als Merkfähigkeit und Arbeitseffizienz bezeichnet. Bei der Merkfähigkeit will der Test das Gedächtnis testen, indem aus einem zu lesenden Text Fragen zu beantworten sind. Damit wird vor allem Textverständnis getestet und nicht die bloße Merkfähigkeit, den Kontext, Vorwissen und Satzbau sind entscheidende Faktoren. Es werden also weder verschiedene abstrakte Formen oder Zusammenhänge präsentiert, um kulturübergreifend und vor allem zum Ausschließen von Vorwissen oder Leseschwäche wirklich nur das Gedächtnis zu prüfen. Angesichts der erschlagenden Menge an Gedächtnisaufgaben in der Kognitionspsychologie ist das erschreckend. Zum Glück ist in den aktuellen Tests der dgp davon eher weniger zu sehen. Auch da hat man wohl erkannt, dass ein PC deutlich mehr Kapazität hat als jeder noch so gute Angestellte oder Beamtin. Aber wir werden später noch andere Hinweise darauf sehen, das viele Tests von Psychologen stammen, die die Errungenschaften moderner Kognitionspsychologie oder Testentwicklung nicht einsehen konnnten oder wollten.

Die Arbeitseffizienz testet man für Behörden über eine alltagsnahe Fachaufgabe aus der Buchhaltung. Wenn man die Aufgabe erstmals sieht, erkennt man sofort, dass so etwas in 80% aller Firmen mittels Excel oder im Intranet mit wenigen Formeln automatisiert zu erledigen wäre und auch so erledigt wird. Die einzige fachspezifische Aufgabe ist seit rund 20 Jahren veraltet.

Eignungstest im Netz: Eligo

Der Wettbewerber eligo geht da ganz anders vor. Zu Beginn absolviert man Test des mehrdimensionalen psychometrischen Modells von Intelligenz, das verbales und numerisches, räumliches und schlussfolgerndes Denkfähigkeiten umfasst (ähnliche wie bei der dgp nur eben online). Dabei gibt es Zeitvorgaben je Aufgabe um Speed- mit Leistungstests zu verbinden. So werden zum Beispiel logische Schlussfolgerungsaufgaben mit einem Zeitlimit von 2 oder 3 Minuten präsentiert und wenn sie nicht gelöst wurden, erscheint schon die nächste Aufgabe. Am Ende addiert man die Zahl der richtig gelösten Aufgaben. Dann weiß man zwar nicht ob man die Geschwindigkeit oder das Leitungsniveau gemessen hat, aber es entstehen Ergebnisse für die Kunden aus der Personalabteilung, die man mit den Ergbnissen der anderen Bewerberinnen und Bewerber vergleicht. Letztlich werden die Besten aller Teilnehmenden ausgesiebt. Leider weiß keiner was da eigentlich gemessen wurde und entsprechend auch nicht, für welche berufliche Dimension die Ergebnisse ein prognostische Validität haben. Aber viele Personaler wollen ja die Besten haben. Insofern erfüllt das Marktbedürfnisse. Wahrscheinlich soll es sich auch um irgendwas mit Intelligenz handeln oder zumindest kognitive Belastung wegen der Zeitvorgabe oder Aussagenlogik? Auch hier ist nicht klar, ob primäre Exekution, attentionale oder kognitive Kontrolle oder Fokussierung die zu prüfenden Konstrukte sind. Auch das ist wieder sehr fern davon eindimensional zu testen und fern von klaren kognitionspsychologischen Konstrukten. Dann folgen Tests zum Gedächtnis und zum technischen Verständnis sowie zur Konzentrationsfähigkeit. Wir erinnern uns, dass jetzt schon fast eine Stunde ins Land gezogen ist, bevor Arbeitshaltungen, Belastungsfaktoren, Kundenorientierung und Führungskompetenz und emotionale soziale Kompetenzen abgefragt werden. Natürlich werden nicht alle Stellenprofile alle Untertests benötigen, aber man erkennt, dass viele Aspekte einer Person getestet werden mit zugekauften Testbatterien, zu denen oft nur teilweise oder gar keine überdurchschnittlichen Werte in Reliabilität und den üblichen Validititäten vorliegen. Auch semi-projektive Verfahren zur Motivmessung (MMG) der Bewerbenden sind enthalten. Die Studienlage zur Validität dazu ist dünn und mehrdeutig, Korrelationen mit berurflich relevanten Zielvariablen sind inkonsistent, wenn überhaupt vorhanden. Bei manchen Untersuchungen konvergieren die hier gemessenen impliziten Motive mit expliziten, in anderen gibt es gar keine Zusammenhänge. Grundsätzlich zeigen Studien, die die drei klassischen Verfahren zur Messung impliziter Motive (PSE, OMT und MMG) gemeinsam erhoben haben, dass sie vorgeben, dasselbe zu messen, aber fast keine Zusammenhänge bestehen zwischen den einzelnen Motivfacetten. Das heißt, sie geben zwar vor, alle dieselben Motive zu messen, tun das aber offensichtlich nicht (Schüler et al, 2015). Zum oben benannten Konstrukt der Frustrationstoleranz ist zu sagen, dass es einem Test zu Arbeitshaltungen von Kubinger und Ebenhöh (1996) entstammt. Die Autoren können keine Angeben zur Reliabilität und Konstruktvalidität vorlegen können ganz zu schweigen von prognostischer Validität. Tja, was soll man mit sowas auch vorhersagen: Bewerbende scheren sich einen Dreck um die unpersönliche Leistungsinformation unbekannter Menschen, wenn man selber an schwierigen Aufgaben sitzt. Es sei denn, sie sind wettberwerbsmotiviert, eines der drei sozialen Grundmotive. Aber das wussten Kubinger und Ebenhöh wohl nicht und auch nicht die Macher bei Eligo. Daher die fehlenden Valditätsangaben. Denn man misst hauptsächlich ein soziales Motiv und die Frustrationstoleranz. Man möchte solche Eignungsdiagnostiker die Cognitive Load Theory von Sweller hundert Mal abschreiben lassen. Aber halt, sie sitzen in Bochum auf einem Lehrstuhl… 😉

Da die Testbatterien aus bestehenden Tests zusammengewürfelt sind, die fast alle in den klassischen des Online-Testportalen bei Hogrefe oder Schuhfried auch zu finden sind, besteht die Frage, warum sollte man die Auswahl bei Eligo buchen, wenn man validere oder modernere Tests zu den einzelnen Aspekte auch bei den professionellen Anbietern direkt findet. Nun man braucht einen Psychologen (Master oder Diplom), der sie dort buchen kann und dann die Ergebnisse für Personaler interpretiert. Es oder sie sollte auf Basis des Stellenprofils das jeweils Passende testökonomisch kurz zusammenstellen und dann ein Profil der Bewerbenden erstellen. Genau das tut Eligo und lässt sich dafür fürstlich bezahlen. Ich kann die Auswahl der einzelnen Tests bei Eligo nicht in jedem Fall nachvollziehen, sie werden sicher auch die einzelnen Tests aktualisieren. Aber wer sowieso kein Stellenprofil hat, keinen Auswahlprozess mit dem Team, keine Langzeit-Evaluation der Eignungsverfahren, der fährt sicher ganz praktisch mit so einem Anbieter, weil alles nach außen Standards erfüllt und objektiv daher kommt. Insofern ist es ausreichend für viele Personalverantwortlichen und die DIN 33430. Testen bei Eligo lässt aber oft den wichtigsten Vorzug von digitalem Testen nach meinem Kenntnisstand bei den meisten Teiltests außer Acht: denn seit einigen Jahrzehnten kann man auch adaptiv Testen. Denn man muss nicht mehr Dutzende Aufgabenergebnisse einer Person aufaddieren oder Mittelwert bilden und mit vielen anderen Ergebnissen einer Referenznorm je nach Alter oder Beruf vergleichen. Denn jede Aufgabe hat ihren einen eigenen Schwierigkeitsgrad und jede Person einen eigenen Fähigkeitsgrad, sie zu lösen und eine gewisse Ratewahrscheinlichkeit. Hat eine Beweberin eine mittlere Aufgabenschwierigkeit zwei Mal korrekt beantwortet, bekommt sie zwei schwere Aufgaben. Solange bis sie genug Fehler macht. Dann hat man ihr Leistungsniveau präzise genug gemessen.

Die Bundesagentur

Der modernste Dienstleister aus meiner Sicht ist ein erfahrener Personal- und Arbeitspsychologe, der auf der Basis einer gemeinsamen Analyse mit dem Team, in dem der/die zukünftige Mitarbeitende bald arbeiten wird, wenige aber aussagekräftige Tests bei Hogrefe (HTS) oder Schuhfried (WTS) online den Bewerbenden präsentiert, auswertet und dann Empfehlungen und/oder eine Rangliste übergibt für die Einladung zu anschließenden multimodalen Interviews. Aber direkt danach kommt eine bisher unbekannte Größe in Personalabteilungen: Der berufspsychologische Service (BPS) der Bundesagentur. Sie verfügen über adaptive Tests, digitale Versionen klassischer Tests wie Matrizentests oder smarte kulturfaire Gedächtnistests und die Möglichkeit, Einzeltests für beinträchtigte Personen in Einzelsettings mit angepassten Zeitvorgaben etc durchzuführen. Letzteres ist neben der Diskussion um kulturfaire und diversitygerechte Eignungstests ein echtes Alleinstellungsmerkmal, das zum Teil auch bei der dgp umsetzbar ist, aber nicht so umfassend.

Die Bundesagentur für Arbeit misst schon lange mit adaptiven Tests in ihren Testlabors im BPS in Großstädten deutschlandweit. Firmen, die die Vorzüge echter wissenschaftlicher adaptiver Leistungsstests schätzen, sollten dort vorstellig werden. Toll, weil diversitätsgerecht ist dort der Testen der Merkfähigkeit: Auf einer Karte fährt ein virtueller Bus durch eine virtuelle Stadtkarte und an jeder Haltestelle wird der Straßenname eingeblendet. Man kann gut sehen, wo Start und Endpunkt sind. Dort dreht der Bus und bei jeder Haltestelle erscheint ein Kästchen und man muss den richtigen Strassennamen wählen, der zu der aktuell angefahrenen Haltestelle passt. Es gibt keine Korrektur, der Bus fährt stumpf seine Linie ab. Dann kommt die nächste Karte und die nächste Buslinie. Das ist sehr clean und sehr auf den Punkt, da der Kontext ÖPNV und eine Karte wirklich jedem geläufig ist. Aus Sicht der Cognitive Load Theory (Sweller et al., 1998) wurde hier fachgerecht auf viel Redundanz (Zusatzinformationen) verzichtet und damit ist anders als bei einigen Aufgaben der anderen Anbietern eine eindeutige Zuordnung der Aufgabenerfüllung zur Gedächtnisleistung erkennbar, was testtheoretisch ein hohe Äquivalenz begründet. Eine möglichst skalare Messinvarianz könnte hier gegeben sein und damit ein gerechtes Verfahren für alle Gruppen aus Sicht der Diversität. Aber auch dazu liegen keine Daten vor, wei bei allen anderen hier beschriebenen Tests. Was für alle drei Anbieter spricht, sie geben die Ergebnisse auch in Bezug auf berufliche Normgrößen an, also mit Bezug auf bestimmte Berufsgruppen. Leider fehlen auch hier die Angaben zur Messinvarianz für eben diese Gruppen, was eine Normierung im Grunde fachlich diskreditiert. Die Verfahren sind alle um Lichtjahre besser als disg oder Myers-Briggs-Typenindikatoren (MBTI) oder sie unseeligen (Team-)Rollenprofile, aber aus meiner Sicht erfüllen sie nicht die Hauptaufgabe des 3. Jahrtausends in der Personalauswahl: Belege liefern, dass geschützte Gruppen nicht benachteiligt werden durch das Messen kognitiver Leistungsfähigkeit. Aus meiner Sicht ist das einer der Gründe, warum das Ziel der Heterogenität aktuell hier und da mit der Brechstange gelöst wird und nicht auf der Basis wissenschaftlicher Psychometrie und erst recht nicht im Einklang mit Erkenntnissen der Sozialpsychologie oder Community Psychology.

Am Ende das Ende: Zielvariablen

Wir haben gesehen, dass bekannte oder teure Anbeiter nicht immer das Testen, was man als Kognition im Berufleben benötigt. Wir haben gesehen, dass den Testentwicklern schwierige Aufgaben nahe an Mathematik oder Logik wichtig sind. Das mag auch im Risikomanagement, in der Buchhaltung oder beim Procurement relevant sein. Ein großer Teil von Aufgaben in Firmen bleibt völlig unberührt. Was aber noch wichtiger ist, es fehlen valide Hinweise, das beruflicher Erfolg mit diesen Tests überhaupt vorhergesagt werden kann – über gemittelte Schulnoten und Abschlussnoten eines Studiums hinaus. Das liegt zum Teil daran, dass beruflicher Erfolg nur verzerrt erhoben werden kann. Der Umsatz einer Abteilung hängt mit der Konjunktur, den Einkaufspreisen, der Kauflaune, dem Wetter und eben den Verkäufern zusammen. Die Bewertung von Mitarbeitenden wird verzerrt durch Ähnlichkeitseffekte, einzelne Projektmeetings, die aktuelle Stimmung im Team oder der Führungskraft und das letzte Treffen wo man länger miteinander gesprochen hat. So gesehen haben viele Verfahren noch nie zeigen können, wie große der Einfluss der gemessenen Konstrukte auf beruflichen Erfolg überhaupt nicht. Von Zeit zu Zeit liest man etas über Metaanalysen wie etwa die von Schmidt & Hunter (1998, 2016), die noch heute zitiert wird, wenn es darum geht, welches Auswahlverfahren das richtige zur Eignungsfeststellung ist. Deren methodische Basis jedoch fehlerhaft (Sackett et al.,2021) Und leider wurden bei Schmidt und Hunter die dort eingerechneten Studien und Effektgrößen nicht korrigiert für den so genannten publication bias, also die Tatsache, das nur Studien mit statistisch signifikanten Prüfgrößen publiziert werden. Zudem ist die Unterscheidung zwischen signifikant und nicht signifkant selber nicht signifikant (Gelman & Stern, 2006), die Auswahkkriterien in Metaanalysen müssen als andere werden. Man sollte bspw. jetzt im Jahr 17 nach der Replikationskrise 2005 alle Metaanalysen ignorieren, die Studien beinhalten, die nicht präregistriert wurden und/oder über eine geringe Teststärke verfügen. Aber gut, dann wären sicher 80% aller Eignungsdiagnosen und Potenzialanalysen nicht mehr valide. Wer will das schon…

Fazit: Wenn Sie junge Leute einstellen, lassen Sie sich die Noten der letzten Jahre geben zu den Hauptfächern und eben den relevanten Kursen der Oberstufe. Bilden Sie Mittelwerte über möglichst lange Zeiträume und sehen sie zu, dass Sie an die Daten kommen, wie Abiturnoten im Vergleich zu anderen Bundesländern zu gewichten sind. In Thüringen haben 38% der Abiturienten eine Gesamtnote besser als 2,0, in Niedersachsen sind das 18%. Testen Sie fachspezifisch, lassen Sie alle an Bewerbungsprozessen im multimodalen Interview schulen und etablieren sie einen Teamauswahl ab dem Zeitpunkt, wo die letzten 3-5 Bewerberinnen und Bewerber fest stehen. Das Team, das eine neue Person aufnimmt sollte eher früher als später einbezogen werden (am besten schon beim Stellenprofil und beim Erstellen der Fachaufgaben. ) und bei der finalen Entscheidung mindestens ein Drittel der Stimme bekommen! Partizipation ist die neue Schwarmintelligenz in der Personalwahl!

Gelman, A. & Stern, H. (2006). The Difference Between “Significant” and “Not Significant” Is Not Itself Statistically Significant. The American Statistician. 60. 328-331. https://doi.org/10.1198/000313006X152649

Howard, G. (2016). Multiple Intelligences: Prelude, Theory, and Aftermath. In R. Sternberg, S. Fiske, & D. Foss (Eds.), Scientists Making a Difference: One Hundred Eminent Behavioral and Brain Scientists Talk about their Most Important Contributions (pp. 167-170). Cambridge: Cambridge University Press. https://doi.org/10.1017/CBO9781316422250.037

Plomin, R., Shakeshaft, N. G., McMillan, A., & Trzaskowski, M. (2014). Nature, nurture, and expertise. Intelligence, 45, 46–59. https://doi.org/10.1016/j.intell.2013.06.008

Sackett, P. R., Zhang, C., Berry, C. M., & Lievens, F. (2021). Revisiting meta-analytic estimates of validity in personnel selection: Addressing systematic overcorrection for restriction of range. Journal of Applied Psychology. Advance online publication. https://doi.org/10.1037/apl0000994

Schmidt, F. L., & Hunter, J. E. (1998). The validity and utility of selection methods in personnel psychology: Practical and theoretical implications of 85 years of research findings. Psychological Bulletin, 124(2), 262–274. https://doi.org/10.1037/0033-2909.124.2.262

Schmidt, F. (2016). The Validity and Utility of Selection Methods in Personnel Psychology: Practical and Theoretical Implications of 100 Years of Research Findings.

Schüler, J., Brandstätter, V., Wegner, M., & Baumann, N. (2015). Testing the convergent and discriminant validity of three implicit motive measures: PSE, OMT, and MMG. Motivation and Emotion, 39(6), 839–857. https://doi.org/10.1007/s11031-015-9502-

Sweller, J., van Merrienboer, J. J. G., & Paas, F. G. W. C. (1998). Cognitive architecture and instructional design. Educational Psychology Review, 10(3), 251–296. https://doi.org/10.1023/A:1022193728205

Zisman, C., Ganzach, Y. (2022): The claim that personality is more important than intelligence in predicting important life outcomes has been greatly exaggerated. Intelligence, 92. https://doi.org/10.1016/j.intell.2022.101631